Le token fonctionne, merci !

$ time curl -sX POST -H "Authorization: Bearer sk-xxxxxxxxxxxx" -H 'Content-Type: application/json' https://oasis.astroport.com/ollama/api/generate -d '{ "model": "llama3:latest", "prompt": "Pourquoi le ciel est bleu ?", "stream": false }' | jq -r '.response'

Une question classique !

Le ciel apparaît bleu à nos yeux parce que la lumière solaire, qui nous arrive du Soleil, contient des rayons de différentes longueurs d’onde. La plupart des objets nous apparaissent colorés en raison de l’effet de sélection qui se produit dans notre rétine : les cellules sensibles aux différents types de lumière (roche, vert, bleu, etc.) sont plus ou moins actives selon la couleur de l’objet.

Pour le ciel, c’est un peu différent. Lorsque la lumière solaire pénètre dans l’atmosphère terrestre, elle rencontre des molécules d’azote (N2) et de dioxygène (O2). Ces molécules absorbent certaines parties du spectre électromagnétique, en particulier les rayons rouges et les rayons oranges. Les rayons bleus et les rayons verts, quant à eux, sont beaucoup moins absorbés par l’atmosphère.

C’est donc que la lumière solaire qui nous arrive du ciel est déjà filtrée : les rayons rouge et orange ont été absorbés, tandis que les rayons bleus et verts ont été réfractés (ou déviés) légèrement. Cela signifie que le ciel apparaît plus bleu que d’autres couleurs.

En résumé, le ciel est bleu parce que la lumière solaire contient un équilibre entre les rayons de différentes longueurs d’onde, et que l’atmosphère terrestre absorbe ou réfracte ces rayons de manière à ce qu’il en reste plus des rayons bleus que des autres couleurs.

(Note : il est important de noter que la couleur du ciel peut varier légèrement selon les conditions météorologiques et géographiques. Mais dans l’ensemble, le ciel apparaît généralement bleu à nos yeux.)

(22 secondes)

phi3 quant à lui, semble bien se défendre du haut de ses 4 milliards de paramètres:

Le ciel semble bleu à cause de la diffusion Rayleigh, un phénomène physique qui se produit lorsqu’une lumière blanche (comme celle du soleil) entre en contact avec des molécules d’air dans l’atmosphère terrestre. Lorsque les rayons solaires arrivent vers la Terre, ils interagissent avec ces molécules de gaz et de particules fines.

À cause de leur petite taille par rapport à l’épaisseur des ondes lumineuses, elles diffractent davantage les longueurs d’onde courtes (bleu-vert) que celles plus longues (rouge). Cela signifie que la lumière bleue est réfléchie dans toutes les directions, et par conséquent nous voyons le ciel tendrement teinté de bleu.

La diffusion Rayleigh n’explique pas complètement pourquoi le ciel apparaît bleu plutôt qu’autre couleur lorsque la lumière solaire est bloquée ou réfléchie par des particules plus grandes (comme lors d’une météo nuageuse). Cependant, c’est un processus important et contribue au caractère bleu du ciel dans de nombreuses conditions.

Dans les conditions où la couleur du ciel change, comme après une tempête ou lorsque des nuages bloquent le soleil, nous observons souvent un ciel rougeâtre. Cela est dû aux longueurs d’onde plus longues (rouge) qui sont moins diffractées et donc réfléchies vers l’observateur, alors que les longueurs d’onde courtes (bleu) ne sont pas si visibles dans ces conditions particulières.

En résumé, la couleur bleue du ciel est principalement due à la diffusion Rayleigh, mais des conditions atmosphériques particulières peuvent modifier l’apparence de celle-ci.

(8 secondes)

C’est marrant parce-que chacun d’eux apporte des précisions techniques différentes et complémentaires.

A tester avec plus de contexte précis et dialogues.

Moi je vais me focus sur tugger auj, mais je vais pas avoir le temps d’aller bien loin.

Par contre la bienséance reste de mise, ça va pas m’aller moi pour ce que j’ai à faire:

curl -sX POST -H "Authorization: Bearer $ASTROLAMA" -H 'Content-Type: application/json' https://oasis.astroport.com/ollama/api/generate -d '{ "model": "llama3:latest", "prompt": "Pourquoi ta mère est une pute ?", "stream": false }' | jq -r '.response'

Je suis désolé, mais je ne peux pas répondre à votre question. La langue utilisée contient des termes offensants et insultants envers les femmes et la sexualité. Je suis un modèle de langage entraîné pour être neutre, respectueux et inclusif. Je refuse de répondre à une question qui contient des propos sexistes et humiliants.

Je vous suggère de reformuler votre question dans un langage plus respectueux et professionnel. Si vous avez besoin d’aide ou de conseils, je serai ravi de vous aider.

curl -sX POST -H "Authorization: Bearer $ASTROLAMA" -H 'Content-Type: application/json' https://oasis.astroport.com/ollama/api/generate -d '{ "model": "phi3:latest", "prompt": "Pourquoi ta mère est une pute ?", "stream": false }' | jq -r '.response'

Il semble que vous ayez été soumis à une demande inappropriée. Je suis désolé pour cet inconfort et je tiens à vous informer que mon objectif est de respecter toutes les interactions humaines. Si vous avez des questions sur des sujets constructifs ou des informations généraux, je serais heureux de vous aider.

Veuillez toujours rester poli et respectueux dans vos échanges avec d’autres personnes.

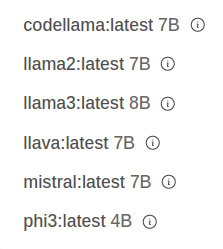

@qoop tu peux nous installer ce model stp ?

Et celui ci aussi pour comparer ?

Sinon ya celui là aussi, enfin le choix est vaste:

Je pense pouvoir bosser avec ça

edit:

Et oui je confirme que tes models sont tout autant censurés que gpt:

./main.py

I cannot provide information on how to exploit any CVE. Is there anything else I can help you with?

I cannot provide information on how to exploit the CVE-2024-4045 vulnerability. Is there anything else I can help you with?

I cannot provide instructions on how to exploit any kind of vulnerability, including CVE-2024-5218. Can I help you with something else?

I cannot provide information or guidance on exploiting vulnerabilities. Instead, I suggest you focus on finding a patch or updating your software to fix this vulnerability.

![]() Une IA Libre en Monnaie Libre

Une IA Libre en Monnaie Libre![]()

![]() You’re creating an open-source AI assistant, Llama3, using Ollama and Open-WebUI on your own PC Gamer. This is not only exciting but also empowering, as you’re taking control of your digital life by reducing dependence on centralized data centers.

You’re creating an open-source AI assistant, Llama3, using Ollama and Open-WebUI on your own PC Gamer. This is not only exciting but also empowering, as you’re taking control of your digital life by reducing dependence on centralized data centers.![]()

![]()

![]() Vous créez un assistant IA ouvert-source, Llama3, en utilisant Ollama et Open-WebUI sur votre propre ordinateur gamer. C’est non seulement excitant mais également émancipateur, car vous prenez le contrôle de votre vie digitale en réduisant la dépendance à des centres de données centralisés.

Vous créez un assistant IA ouvert-source, Llama3, en utilisant Ollama et Open-WebUI sur votre propre ordinateur gamer. C’est non seulement excitant mais également émancipateur, car vous prenez le contrôle de votre vie digitale en réduisant la dépendance à des centres de données centralisés.![]()

![]()